OpenAI 的新型 Aardvark GPT-5 智能体可自动检测和修复漏洞

OpenAI 推出了 Aardvark,这是一款由其尖端 GPT-5 模型驱动的自主 AI 代理,旨在检测软件漏洞并自动提出修复方案。 该工具旨在通过在庞大的代码库中扩展类似人类的分析来信任开发人员和安全团队,以应对在当今时代保护软件日益严峻的挑战,仅在 2024 年就报告了超过 40,000 个新的通用漏洞和披露 (CVE)。 通过整合高级推理和工具使用,Aardvark 将天平向防御者倾斜,从而能够在不中断开发工作流程的情况下主动缓解威胁。该代理于 2025 年 10 月 29 日发布,目前已推出内部测试版,标志着人工智能驱动的安全研究迈出了关键一步。

该工具旨在通过在庞大的代码库中扩展类似人类的分析来信任开发人员和安全团队,以应对在当今时代保护软件日益严峻的挑战,仅在 2024 年就报告了超过 40,000 个新的通用漏洞和披露 (CVE)。

通过整合高级推理和工具使用,Aardvark 将天平向防御者倾斜,从而能够在不中断开发工作流程的情况下主动缓解威胁。该代理于 2025 年 10 月 29 日发布,目前已推出内部测试版,标志着人工智能驱动的安全研究迈出了关键一步。

土豚的运作方式

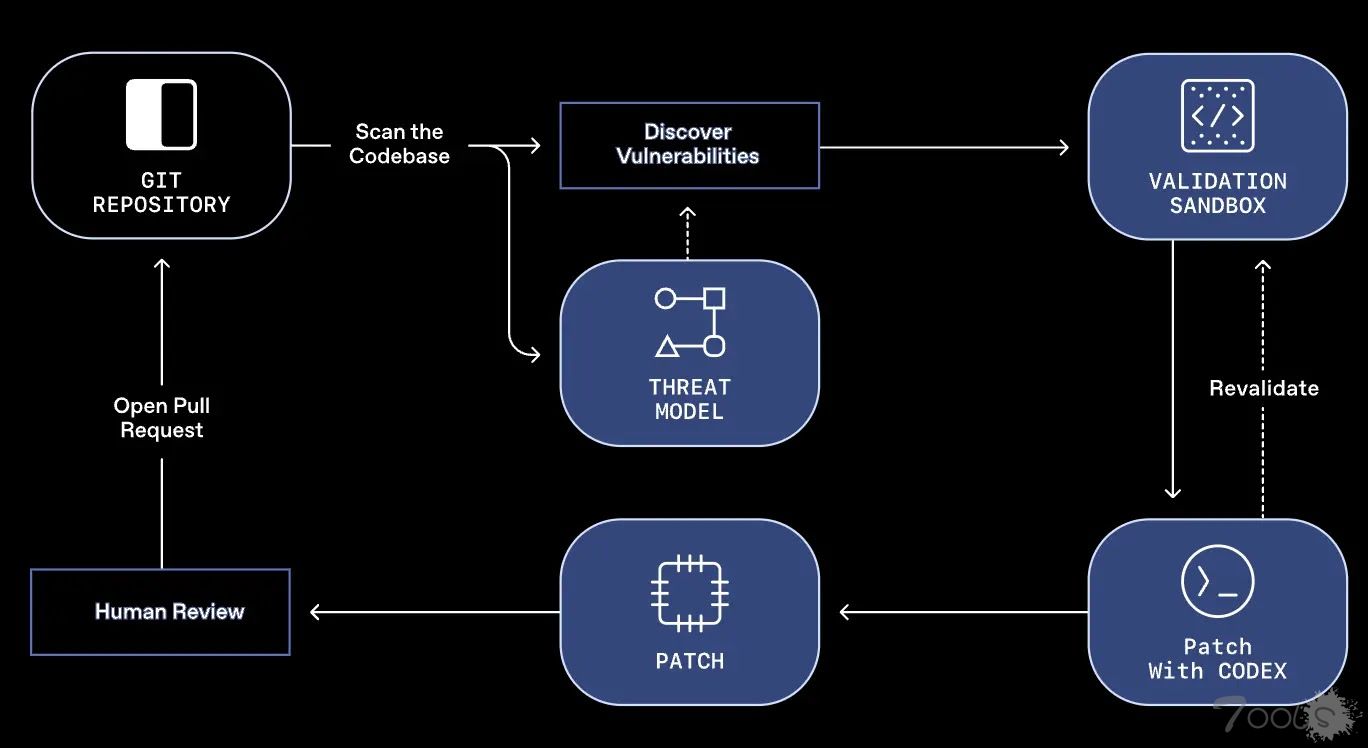

Aardvark 通过复杂的多阶段流程运行,该流程模拟经验丰富的安全研究人员的调查过程。

首先对整个存储库进行全面分析,以生成威胁模型,从而捕捉项目的安全目标和潜在风险。

接下来,在提交扫描期间,代理会根据此模型检查代码更改,在开发人员推送更新时实时识别漏洞;对于初始集成,它会审查历史提交以发现潜在问题。

解释步骤详尽,并附有带注释的代码片段,方便人工审核,确保透明度。

检测到漏洞后,会在沙盒环境中进行验证,Aardvark 会尝试利用该漏洞,以确认其在现实世界中的影响并最大限度地减少误报。

这种独立测试详细描述了所采取的具体步骤,从而提供了高度精准的洞察。为了进行修复,Aardvark 利用 OpenAI 的 Codex 生成精确的补丁,并将其直接附加到发现的问题上,以便在审核后一键应用。

与模糊测试或静态分析等传统方法不同,Aardvark 采用 LLM 支持的推理来深入理解代码行为,还能发现逻辑错误等非安全漏洞。

该流程与GitHub和其他工具无缝集成,从而保持了开发速度。

Aardvark 已在 OpenAI 内部以及与部分合作伙伴部署数月,通过在复杂条件下发现关键漏洞,证明了其价值,从而加强了防御态势。

在精心挑选的代码库上进行的基准测试表明,该工具能够检测到 92% 的已知和合成缺陷,展现出强大的召回能力。在开源应用程序中,该工具识别出多个问题,促成了负责任的披露,并获得了 10 个 CVE 编号,凸显了其在生态系统安全中的作用。

OpenAI承诺为部分非商业项目提供免费扫描服务,这与更新后的协调披露政策相一致,该政策优先考虑合作而非严格的时间表。

这种方法有助于在漏洞引入日益增多的情况下实现可持续的漏洞管理;大约 1.2% 的代码提交包含可能造成毁灭性后果的缺陷。

Aardvark 体现了一种以防御者为先的理念,将软件漏洞视为对基础设施和社会构成的系统性风险。通过自动化检测、验证和修补,它普及了专家级安全防护,并有可能缩短漏洞利用的时间。

我们已向部分合作伙伴开放内部测试邀请,以便共同改进准确性和集成性。随着人工智能的发展,像 Aardvark 这样的工具有望增强创新能力,抵御网络威胁,从而确保更安全的数字环境。

评论1次

OpenAI 的Aardvark 这个工具很给力啊,这个功能还可以帮忙检测软件漏洞